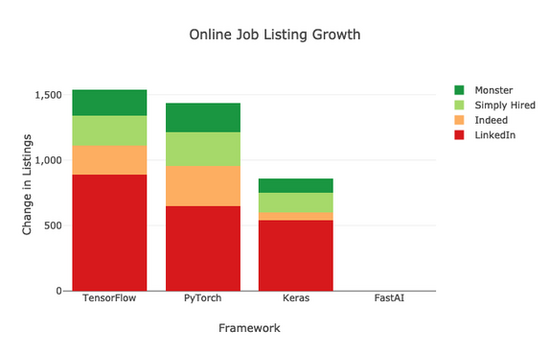

⭐TensorFlow已被廣泛應用於電腦視覺、語音辨識、自然語言處理、音訊辨識與生物資訊學等等。

⭐本課程適合已有Python程式基礎者

課程內容

Tensorflow深度學習原理與實作1 (2:18:51)

- 00:00:00 ~ 00:18:19 老師與課程介紹

- 00:18:19 ~ 00:43:08 深度學習軟體開發架構

- 00:43:08 ~ 00:48:40 必要套件(Scipy 與 Scikit-Learn)

- 00:48:40 ~ 01:12:20 開發環境介紹

- 00:12:20 ~ 01:52:30 神經元計算(NeuroComputing)與機器學習

- 01:52:30 ~ 02:18:51 範例 : 圖形識別流程(魚種分類)

Tensorflow深度學習原理與實作2 (2:07:31)

- pandas套件讀取與收入資料集(Income Dataset)處理

Tensorflow深度學習原理與實作3 (2:16:01)

- 00:00:00 ~ 00:15:50神經元基本模型

- 00:15:50 ~ 00:28:01激活函數(Activation Function)

- 00:28:01 ~ 01:35:30梯度下降法(Gradient Descent)

- 01:35:30 ~ 01:42:20多層感知器(Multilayer Perceptron)

- 01:42:20 ~ 02:00:25倒傳遞演算法(Backpropagation)

- 02:00:25 ~ 02:16:01資料前處理(Preprocessing)

Tensorflow深度學習原理與實作4 (2:33:13)

- 00:00:00 ~ 00:23:10 資料表示與範例實作(收入資料集)

- 00:23:10 ~ 00:40:17 一般化與過度擬合範例實作

- 00:40:17 ~ 01:19:40 建立模型與訓練實作

- 01:19:40 ~ 01:37:00 改變學習率(Learning Rate)實作

- 01:37:00 ~ 01:43:00 固定初始權重(Initial Weights)

- 01:43:00 ~ 01:54:20 特徵縮放實作

- 01:54:20 ~ 02:03:30 參數儲存與載入

- 02:03:30 ~ 02:33:13 如何使用Google CoLab

Tensorflow深度學習原理與實作5 (1:41:34)

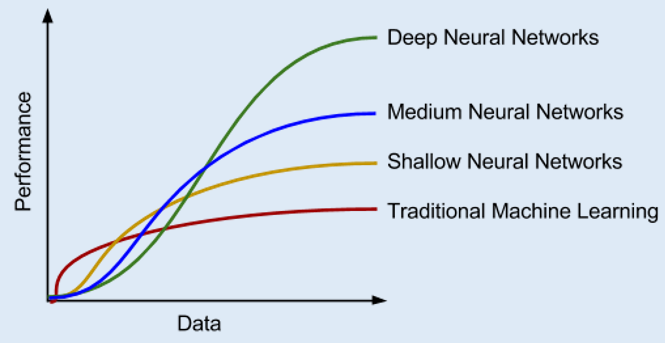

- 00:00:00 ~ 00:04:08 深度學習(Deep Learning)

- 00:04:08 ~ 00:31:24 線性整流函數(Relu)

- 00:31:24 ~ 00:50:40 交叉熵誤差(Cross-Entropy Error)

- 00:50:40 ~ 01:41:34 梯度下降優化版本與實作

Tensorflow深度學習原理與實作6 (1:42:55)

- 00:00:00 ~ 00:05:12 避免過度擬合方法

- 00:05:12 ~ 00:08:09 避免過度擬合方法一 : 資料擴增(Data Augmentation)

- 00:08:09 ~ 00:37:16 避免過度擬合方法二 : 交叉驗證(Cross Validation)

- 00:37:16 ~ 00:53:20 避免過度擬合方法三 : 調節(Regularization)

- 00:53:20 ~ 01:06:24 避免過度擬合方法四 : Dropout

- 01:06:24 ~ 01:42:55 避免過度擬合方法五 : Batch Normalization